Dan begint er toch iets structureel mis te gaan?

AI helpt bij het opslaan van recepten.

Ook nu stond de ondertiteling uit bij het YouTube filmpje, maar dat is gelukkig geen probleem meer.

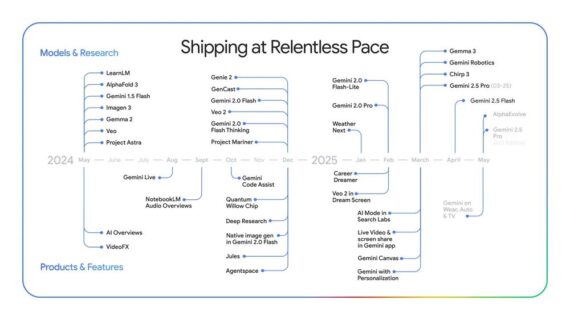

Weer een nieuwe uitbreiding!

Wethouder gaat gevecht aan met buurtbewoners.

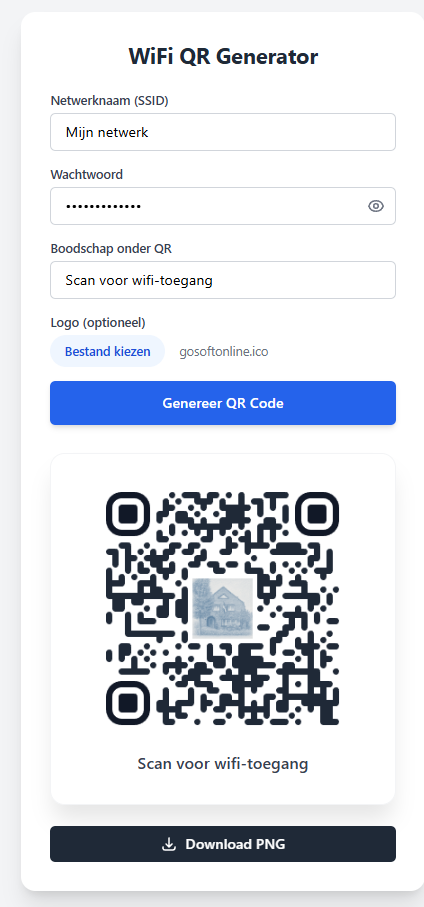

Wil je veel controle en wat meer werk of juist eenvoud?

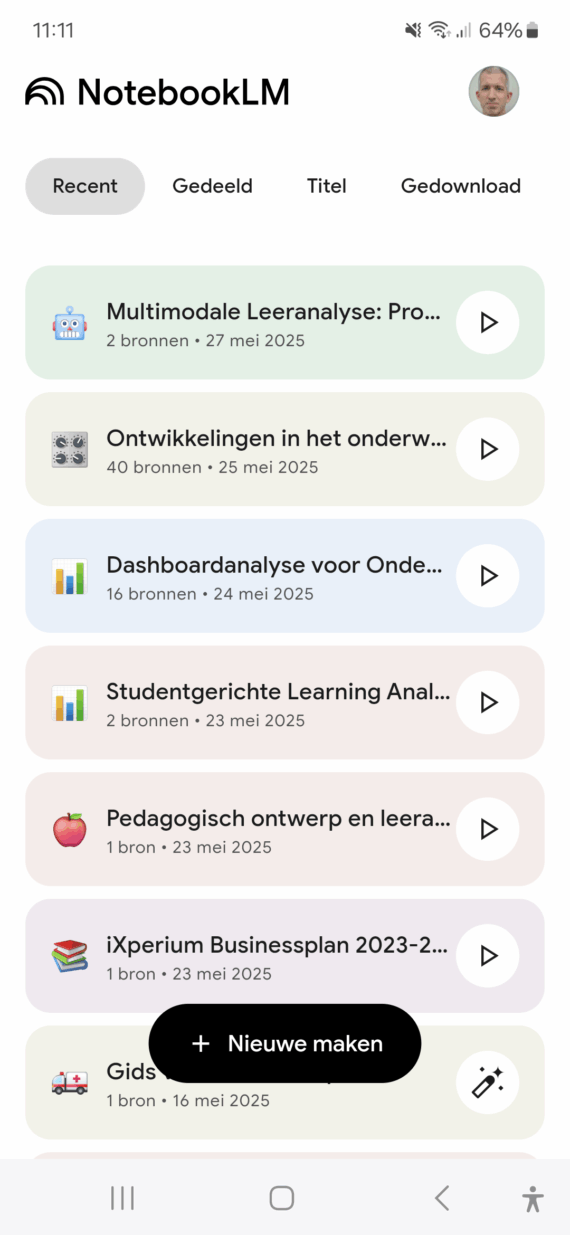

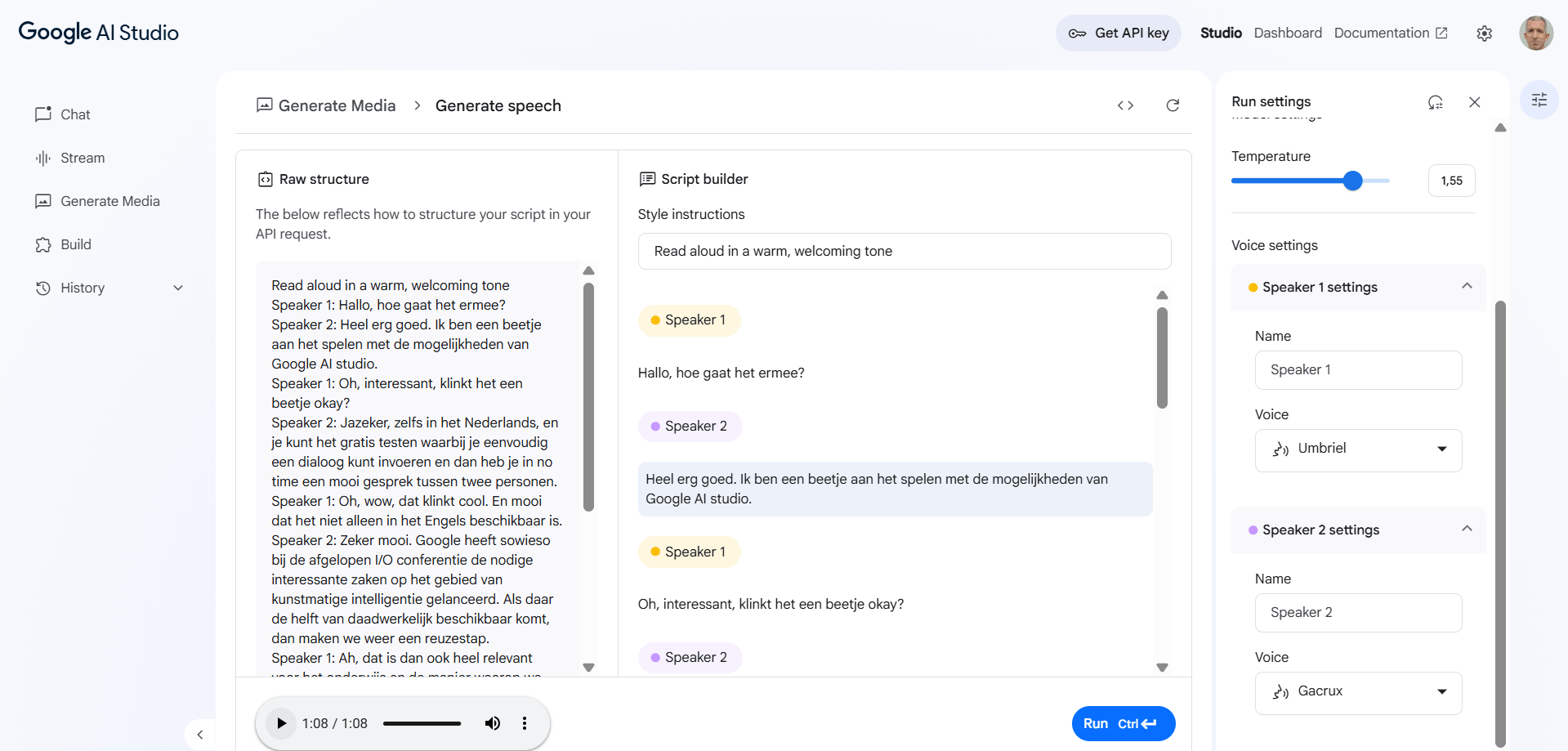

Een van de indrukwekkende features in NotebookLM die kortgeleden uitkwam was de mogelijkheid om het podcastgesprek tussen twee personen over de documenten die je daar toegevoegd had, ook in het Nederlands plaats te laten vinden. Die feature is bijzonder omdat het niet zomaar twee verschillende stemmen zijn die na elkaar stukjes van een verhaal vertellen, maar het lijkt alsof ze in […]

Niet alleen de zoveelste techconferentie van een groot bedrijf.

De resultaten zijn zeker niet slecht.

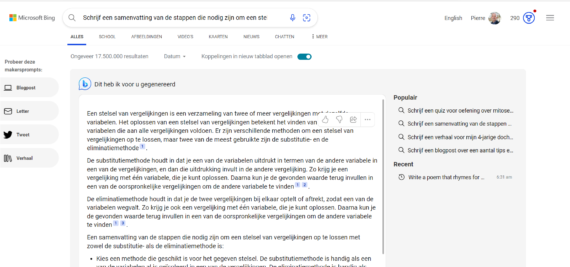

Het staat 1-0 voor Microsoft in haar poging om stukjes van de 90% marktaandeel die Google heeft op de zoekmarkt af te snoepen. Hoe? Met ChatGPT!