Dan begint er toch iets structureel mis te gaan?

AI

64 posts

Kijken of ik het kan versnellen.

In tegenstelling tot vorig jaar ligt de focus nu (uitsluitend) op generatieve AI

Maar wel bijna overal.

Afgelopen week verscheen er een interessante aflevering van de AI in Education podcast waarin Ray Fleming in gesprek gaat met Aaron Driver van de University of New England in Autstralië over de manier waarop zij studenten toegang geven tot AI via een platform dat ze breed in de universiteit aanbieden. Niet alleen is het platform interessant, het gegeven dat ze de […]

Voor nu dan in ieder geval.

AI helpt bij het opslaan van recepten.

Ook nu stond de ondertiteling uit bij het YouTube filmpje, maar dat is gelukkig geen probleem meer.

Heb jij hem ooit gebruikt?

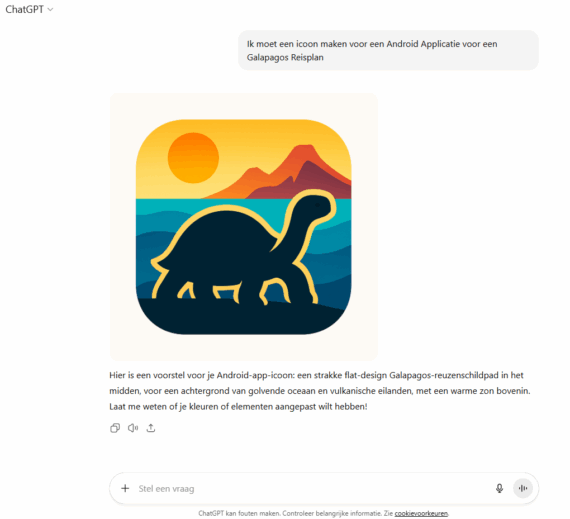

Kan ik met AI een app maken voor Android?