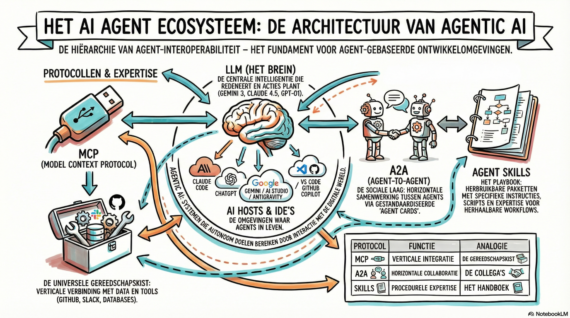

Het is mooi om samen te werken met AI, maar vanzelf gaat het niet.

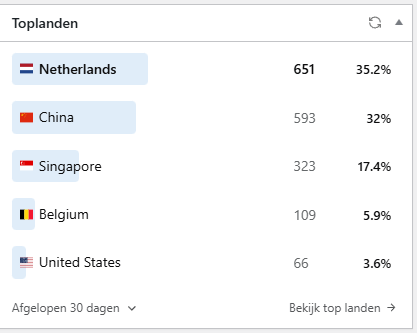

Internet

1534 posts

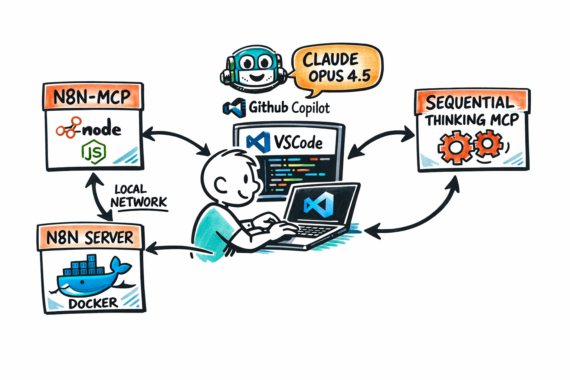

Alle cool kids gebruiken Claude Code, maar wat als je die niet hebt?

Dan begint er toch iets structureel mis te gaan?

Nog maar een verhaal over het in de lucht houden van deze site.

Het zelf hosten van een blog is ingewikkeld geworden.

📻 NRC Vandaag is een podcastserie die de moeite waard is om standaard in je luisterlijst te hebben.

📅 Vandaag meegedaan met de 🎵Nationale Geluidmeetdag.

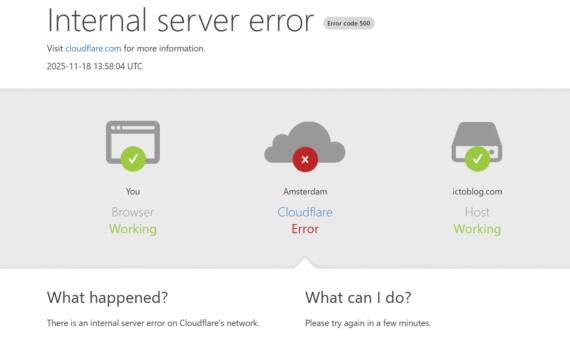

Cloudflare had even problemen…

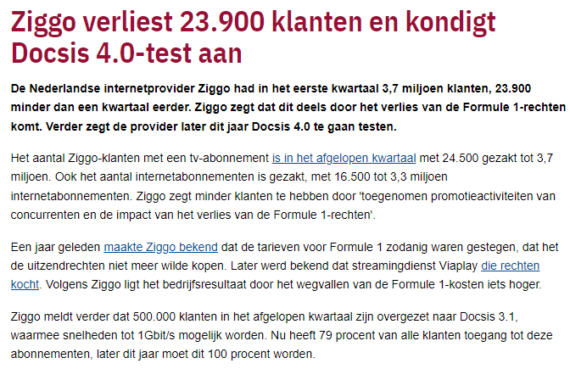

Na 16 jaar gaat UPC/Ziggo hier ook voor TV de deur uit.

Ik zou ze niet gebruiken om Twitter te kopen….