Weer een nieuwe uitbreiding!

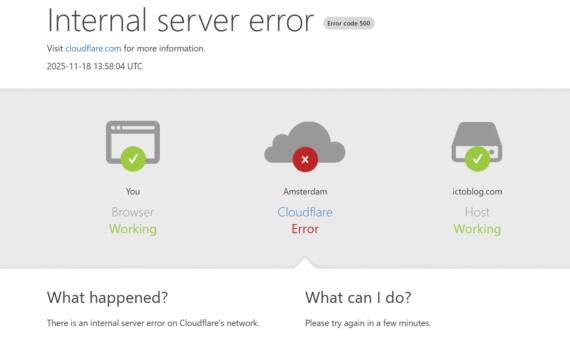

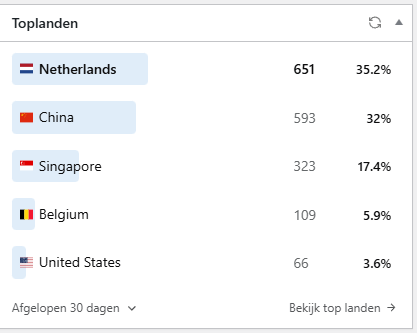

Nog maar een verhaal over het in de lucht houden van deze site.

Het zelf hosten van een blog is ingewikkeld geworden.

Of course it depends….

Naast audio, nu ook video op basis van de documenten die je upload naar NotebookLM.

Heb jij hem ooit gebruikt?

Kun je op de DeepThink of “Doe diepgaand onderzoek” opties van taalmodellen vertrouwen?

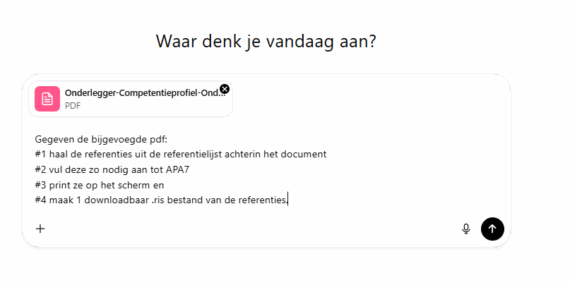

Onderzoeksrapportage met interessante literatuur die je wilt bewaren?

Zeg jij het maar: slim, handig of oerdom?

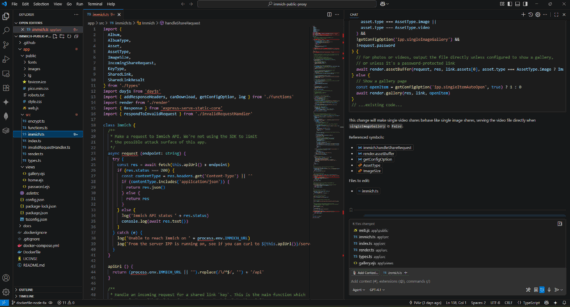

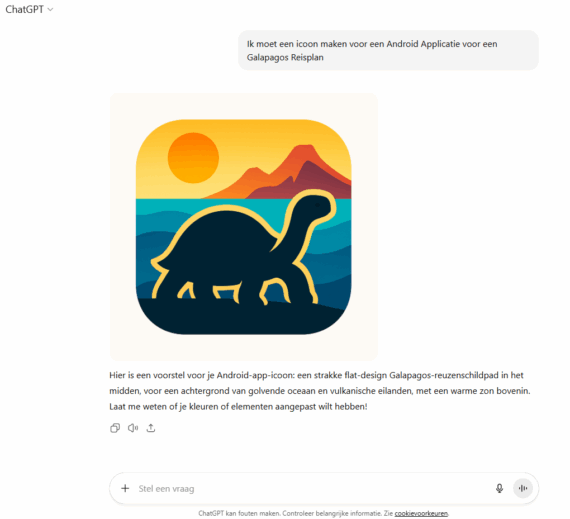

Kan ik met AI een app maken voor Android?