Weer een nieuwe uitbreiding!

Tools

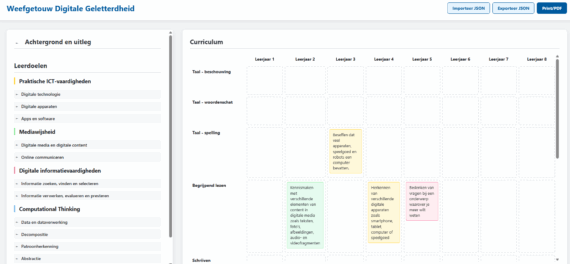

AI Studio maakt het weefgetouw draagbaar.

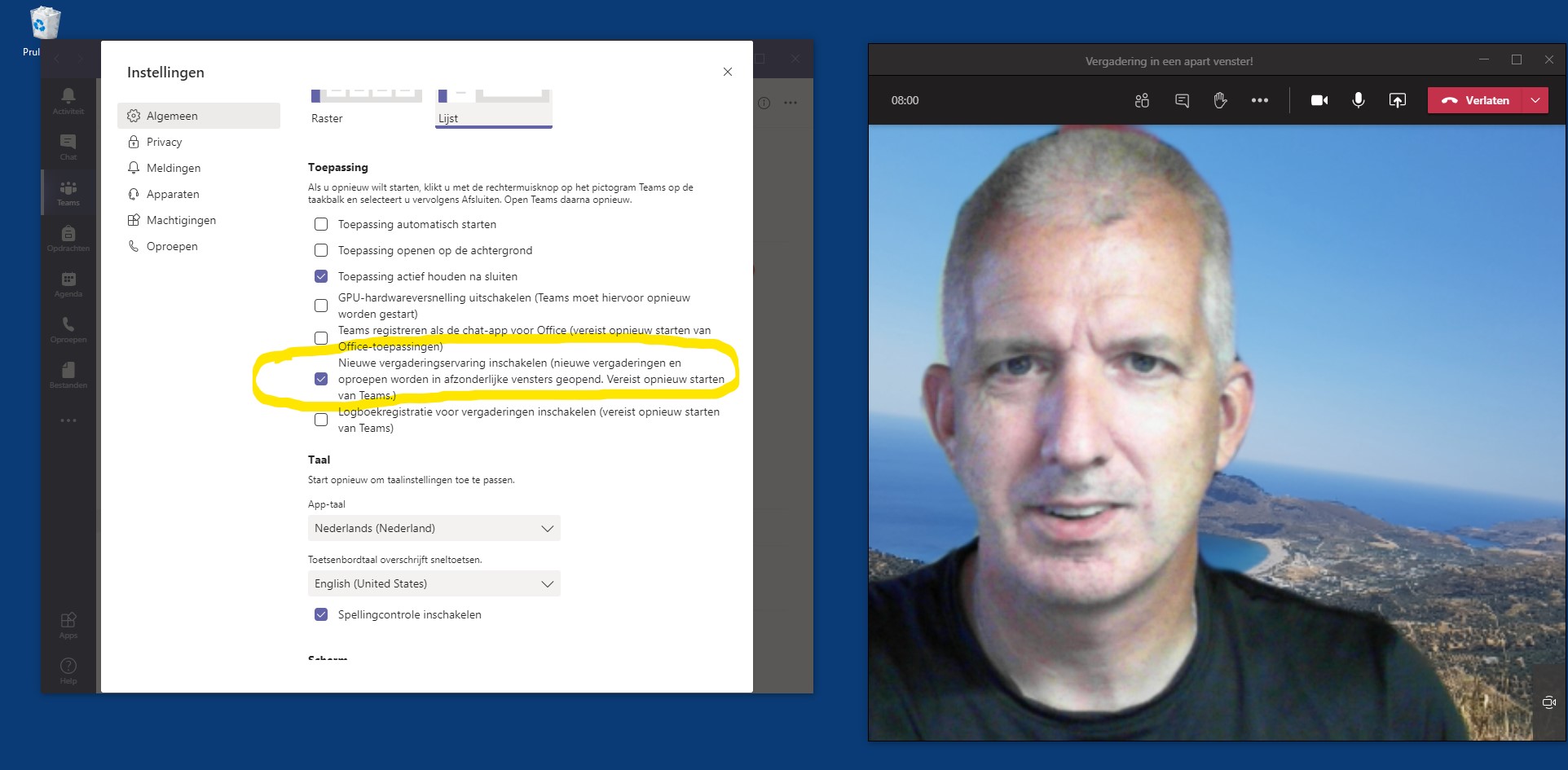

Het is logisch, voor de vakantie schreef ik dat het voor na de vakantie was, en het is nu na de vakantie en zo te zien hebben wij inmiddels ook de nieuwe vergaderoptie beschikbaar waarbij Teams vergaderingen in een apart venster geopend worden en die gekke balk naar boven verschoven is. Volgende week heb ik volgens mij voor het eerst een […]

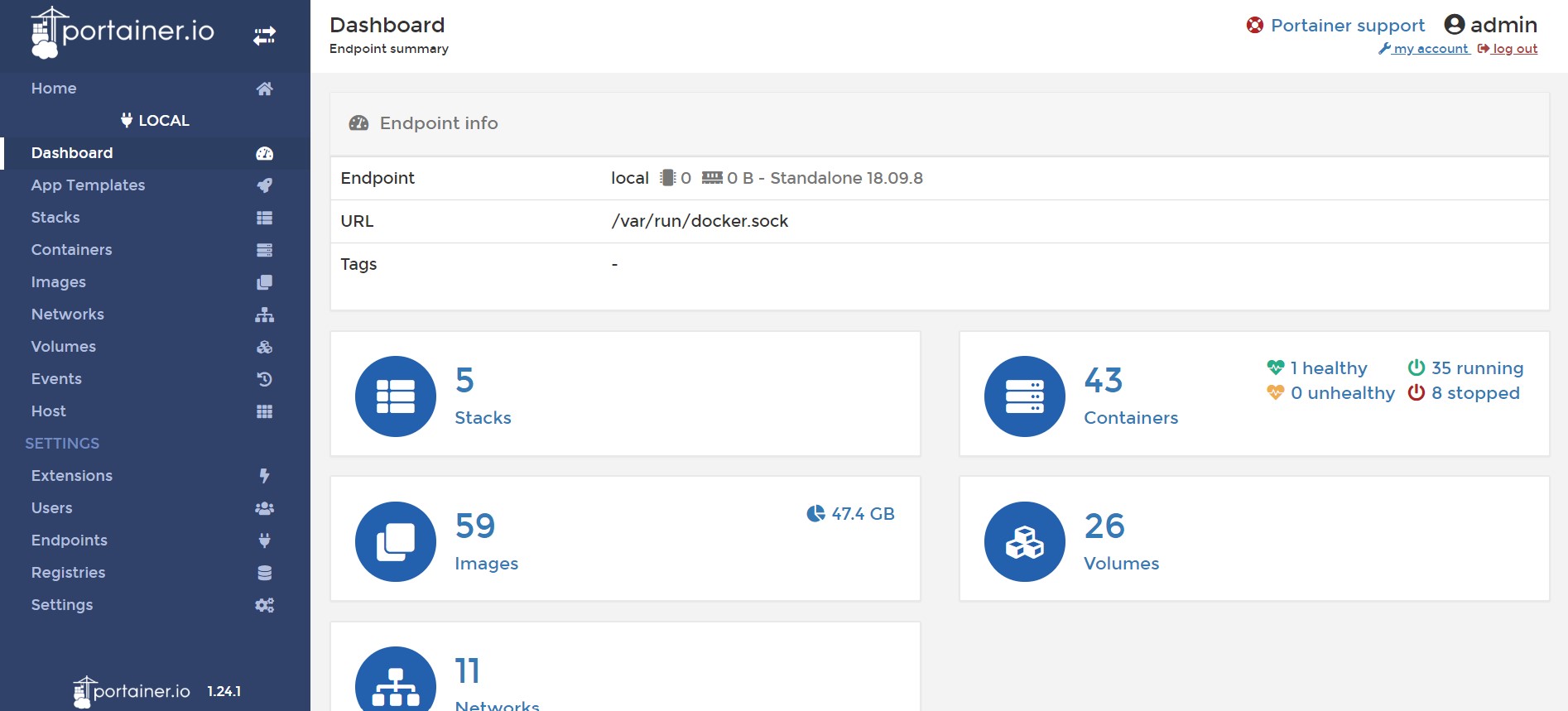

Volgens Portainer draaien er op dit moment 35 Docker containers op mijn NAS (en 8 zijn geïnstalleerd maar staan uit). De oudste container die nog actief is, is van september 2019, 10 maanden geleden dus. In de tussentijd heb ik het nodige bijgeleerd als het gaat om het aanmaken en runnen van Docker containers. Zo heb ik me aangeleerd om voor […]

Learning Locker, de LRS die we gebruiken voor de pilot/demonstrator binnen Allyoucanlearn (zie ook deze aantekeningen) heeft ingebouwde mogelijkheden voor het bouwen van dashboards. Tot nu toe heb ik daar niet zo’n heel goede ervaringen mee. Het maken van overzichten die zouden kunnen dienen als voorbeelden voor gebruik tijdens gesprekken met docenten en studenten als het gaat om hun behoeften aan […]

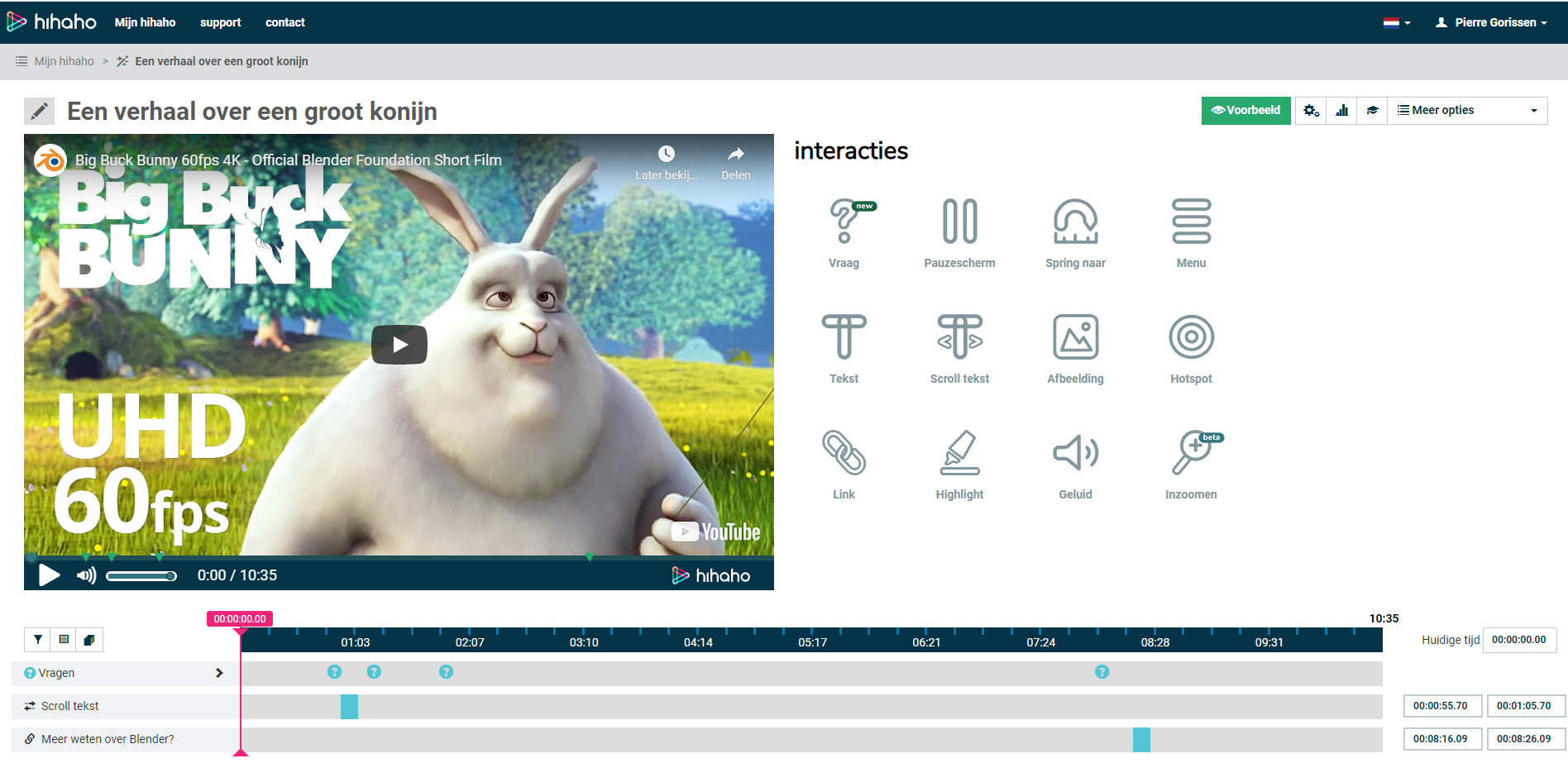

Dit wordt weer eens zo’n “ik moet het even opschrijven want morgen ben ik het anders weer vergeten, maar dat betekent ook dat het waarschijnlijk niet de meest gestructureerde blogpost wordt” blogpost. Voor een van de samenwerkingsverbanden (Allyoucanlearn) ben ik, samen met JaapJan Vroom van het Deltion College bezig met een deelproject waarbij we een demonstrator realiseren om met docenten en […]

The Coding Train is eigenlijk een site die niet heel veel toelichting nodig heeft. Je kunt beter gewoon een paar filmpjes van Daniel Shiffman bekijken. Dan weet je snel genoeg of het iets voor je is of niet. Ik kwam er zelf pas heel recent langs, deze maffe aflevering van Coding in the Cabana was mijn kennismaking. Daarna bekeek ik ook […]

Dat arme GIF. Ooit was het geliefd, toen controversieel vanwege de patenten die er op zaten. Toen die eenmaal verlopen waren ontdekten mensen dat je ook animaties kon maken met een GIF en wat ooit een “animated GIF” was, werd gewoon een “GIF” (uitgesproken als “JIF” blijkbaar). En ik moet bekennen dat ik er ook een fan van aan het worden […]

Dit bericht valt in de categorie “hoezo, daar had je nog niet van gehoord?”. Mijn internet-router thuis heeft een firewall, mijn laptop en mijn desktop hebben een firewall. Voor Linux had ik wel eens van iptables gehoord, maar dat was zo’n mysterieus ding waar ik nooit verder ingedoken was. Als je “gewoon” een website hebt op een shared server, dan doe […]

Ik kreeg via de mail een vraag over Node-RED en InfluxDB, maar had net even geen server beschikbaar met beide geïnstalleerd. Hoe kon ik nu testen of ik het probleem kon reproduceren? Docker to the rescue! Ik heb op mijn laptop Docker geïnstalleerd staan. Ik kan nu niet helemaal uitleggen wat Docker is en hoe je het installeert, zie daarvoor ook […]